本文已收录到:机器学习笔记 专题

- 机器学习的学习顺序、书籍和一些体会

- 朴素贝叶斯 – 根据男性特征分析女性是否嫁的问题

- 感知机 – 一种二分类线性分类模型,划分红豆和绿豆

- 逻辑斯谛回归 – 不那么生硬的划分红豆和绿豆

- 支持向量机:线性可分支持向量机与硬间隔最大化

- 支持向量机:线性可分支持向量机与软间隔最大化

- 利用集成方法提高基分类器分类性能

- 集成方法之Bagging装袋法:三个臭皮匠投票、少数服从多数

- 集成方法之Boosting提升方法:更像现实中实际学习的模型

- 决策树不仅可以做分类,还可以回归:回归树

- K-均值聚类算法,对无标签数据进行分组汇聚

- Apriori算法进行关联分析

- 使用FP-growth算法高效的挖掘海量数据中的频繁项集

- 维度是什么?数据降维方法,降维的用途

- 最广泛的降维算法:主成分分析(PCA)【原理讲解+代码】

- 人工神经网络(ANN)及BP算法原理

- 深度学习常用数据集、发展脉络和工具框架介绍

- 自编码器 – 经典的无监督学习神经网络、领会它的思想

- 卷积神经网络:卷积就是特征提取器,就是CBAPD

- 循环神经网络(RecurrentNN):有记忆的神经网络

深度学习常用数据集介绍

- mnist手写数字数据集:http://yann.lecun.com/exdb/mnist/

- ImageNet:https://image-net.org/challenges/LSVRC/index.php

前沿:目前来说,深度学习的算法大家都差不多,已经逐渐变成比拼数据集量大小。

改造人工神经网络,引入深度学习模型

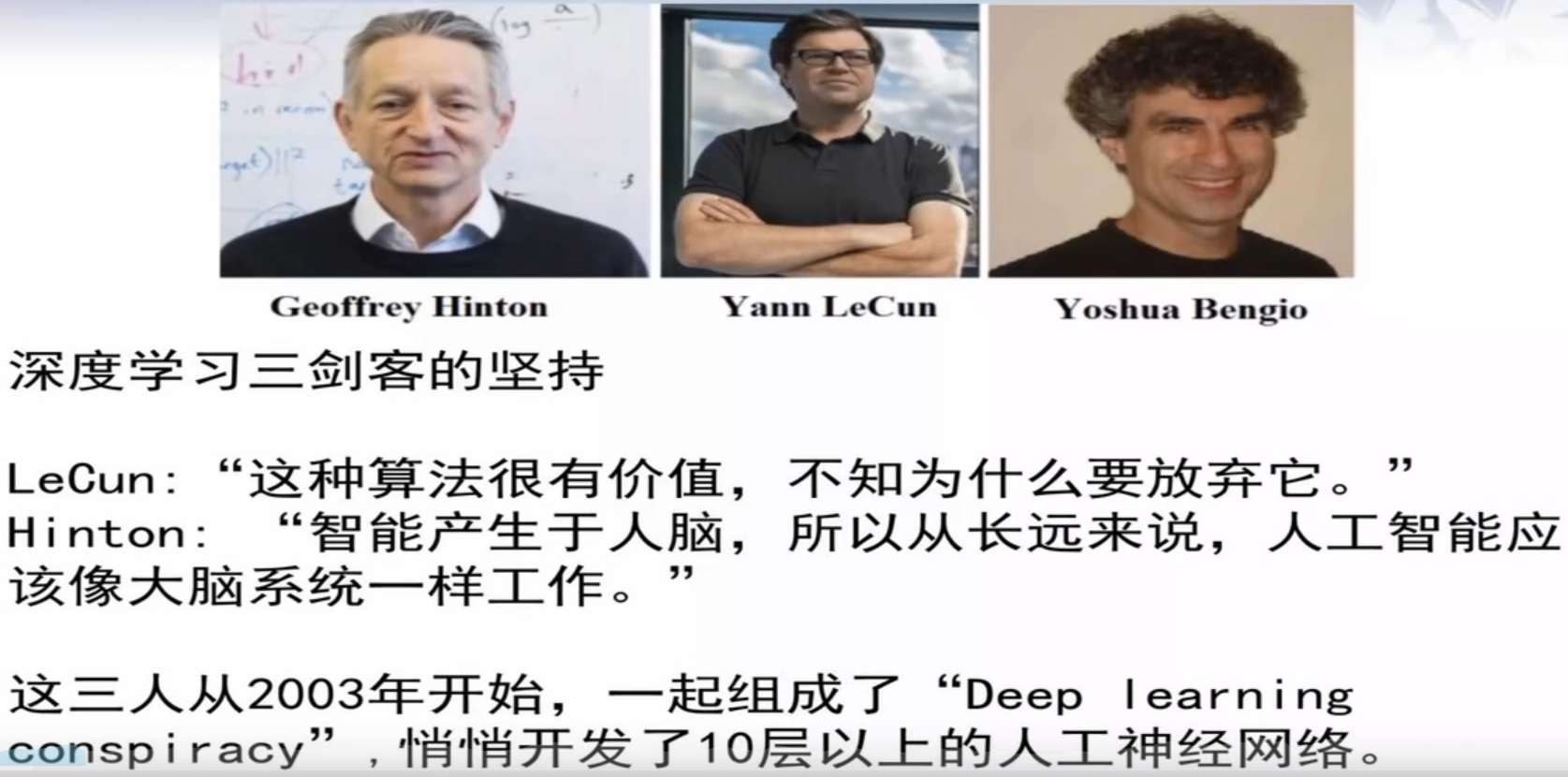

人工神经网络在此之前有过一段的沉寂期,在当时发现小样本情况下SVM甚至比人工神经网络更好,而人工神经网络的数学推导又不是很清晰,当时发表文章很难。

随后在2003年,神经网络开始发力:

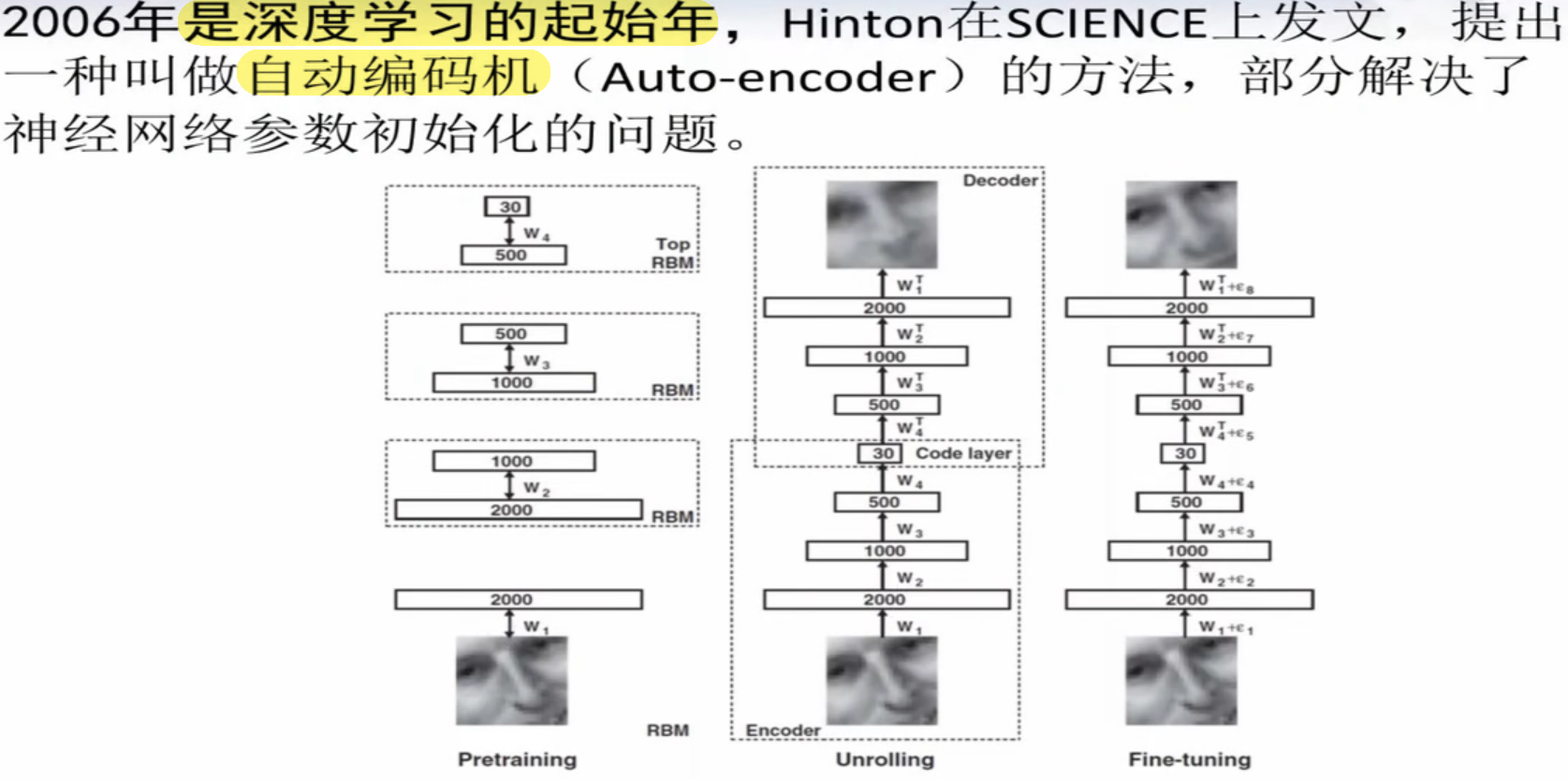

自编码器

请注意,我们本节所讨论的内容都是历史沿革,并不代表ANN、自编码器这些内容现在还很重要,目前来说,自动编码机并没有太大的用途。

上图是06年Hinton发表的论文,介绍了自动编码机这种方法,但06年那会这篇文章没有使用神经网络,而是使用了一种受限玻尔兹曼机(RBM)——目前已经基本不用了。这里只是讲了一个思想,使用RBM还是神经网络只是具体实现问题,影响不大。

当时用于压缩、减少神经元个数,是一种提取特征的行为。

具体内容请看后续的自编码器文章。

卷积神经网络(CNN)

具体内容请看后续的卷积神经网络文章。

深度学习工具

Tensorflow和Caffee。